Los modelos de lenguaje como ChatGPT, Gemini o Claude están redefiniendo la relación entre tecnología y conducta humana. Capaces de generar texto, responder preguntas y simular conversaciones, estas herramientas han sido adoptadas en clínicas, escuelas, organizaciones y centros de investigación. Pero hay una pregunta incómoda que merece ser atendida: “¿Está la investigación en inteligencia artificial comprendiendo realmente la psicología que cita?”

Un reciente estudio titulado «The Incomplete Bridge: How AI Research (Mis)Engages with Psychology» analiza 1.006 artículos científicos sobre LLMs publicados entre 2023 y 2025. Los autores revelan que, aunque el campo de la IA está citando cada vez más literatura psicológica, muchas veces lo hace de forma superficial o fragmentaria.

Citar no es comprender. Integrar teorías psicológicas en IA exige más que referencias bibliográficas.

Te dejo el vídeo del podcast donde se analiza en profundidad el artículo

El estudio

Estos sistemas, conocidos como Modelos de Lenguaje Grandes (LLMs), pueden escribir poesía, razonar sobre problemas complejos y hasta simular empatía. Pero aquí está el secreto: sus propios creadores no entienden del todo cómo lo hacen. Y para intentar descifrarlo, están mirando hacia nuestro campo, la psicología

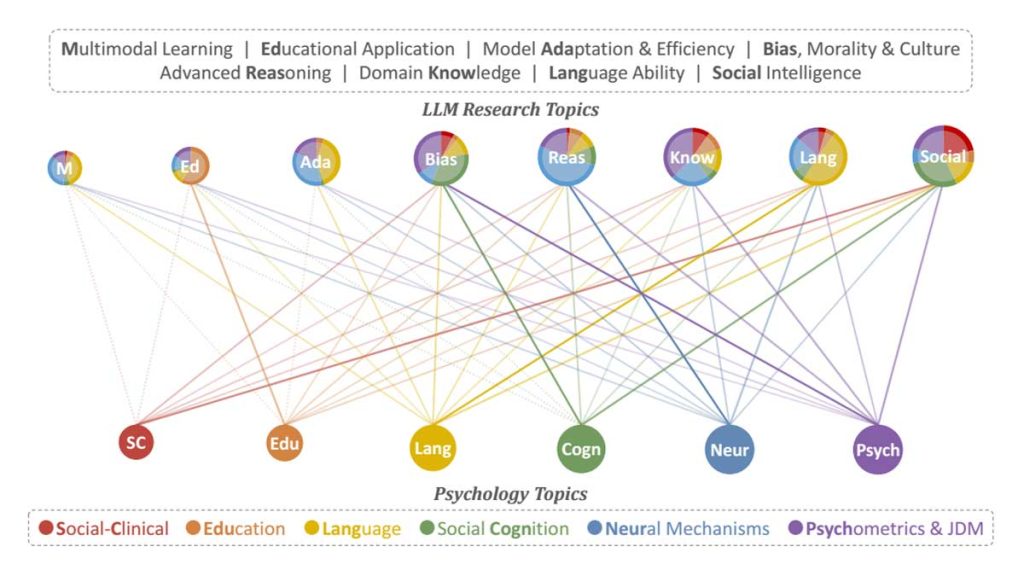

Un reciente y fascinante estudio titulado «The Incomplete Bridge: How AI Research (Mis)Engages with Psychology« (El Puente Incompleto: Cómo la investigación en IA se relaciona (y malinterpreta) con la Psicología) ha puesto bajo el microscopio esta relación. Los autores analizaron más de 1.000 artículos de investigación en IA que citaban más de 2.500 trabajos de psicología. Los resultados son un mapa revelador de lo que la IA valora de nuestra disciplina, lo que ignora y, lo más importante, dónde nos necesita urgentemente.

Primero, un poco de jerga técnica (explicada para nosotros)

Antes de sumergirnos en los hallazgos, aclaremos dos conceptos clave del estudio:

- Modelos de Lenguaje Grandes (LLMs): Piensa en un LLM como un «cerebro estadístico» gigantesco. No «entiende» el lenguaje como nosotros, sino que ha sido entrenado con una biblioteca equivalente a todo internet para predecir la siguiente palabra más probable en una secuencia. Sus capacidades para generar texto coherente y realizar tareas complejas son «emergentes», es decir, surgieron de la escala masiva de datos y computación, sin haber sido programadas explícitamente. Esta es la razón de su naturaleza de «caja negra».

- Clustering y Embeddings: Para analizar miles de artículos, los investigadores usaron una técnica para agruparlos por temas. Primero, convirtieron el título y el resumen de cada artículo en una serie de números (un «embedding») que representa su significado. Luego, usaron un algoritmo de «clustering» para encontrar grupos de artículos con significados similares. Así es como identificaron los grandes temas de investigación tanto en IA como en las citas de psicología.

El Mapa de la Colaboración: ¿Qué toma y que no la IA de la Psicología?

El estudio revela un panorama fascinante y desigual. Hay un interés creciente en la psicología, pero la atención no se distribuye por igual.

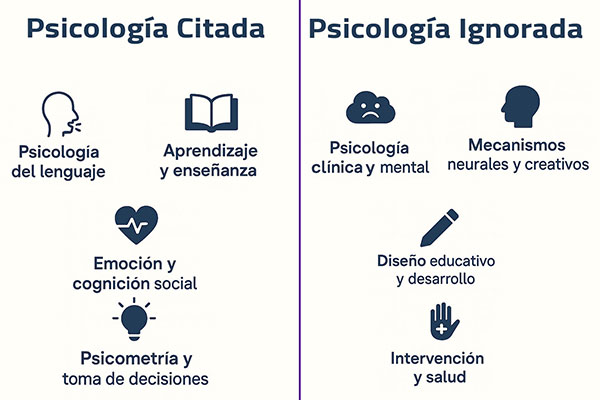

Las áreas más «populares» de la psicología para la IA son:

- Psicometría y Toma de Decisiones: Este es el campo estrella. La IA recurre masivamente a trabajos sobre heurísticas y sesgos (gracias, Kahneman y Tversky) y a la Teoría Clásica de los Tests. ¿Por qué? Principalmente para evaluación. Los investigadores de IA crean benchmarks (pruebas estandarizadas) para medir las capacidades de sus modelos, y usan nuestros métodos para validar esas pruebas y ver si los LLMs replican los mismos sesgos cognitivos que los humanos.

- Mecanismos Neurales y Psicología Cognitiva: Conceptos como «atención selectiva» o «memoria de trabajo» han inspirado directamente la arquitectura de estos modelos. La idea de redes neuronales que se fortalecen con el uso (hola, Hebb) es la base de su aprendizaje.

Las áreas menos citadas son:

- Modelo biopsicosocial: ideal para analizar interacciones entre salud, contexto y comportamiento.

- Teorías educativas como la de Vygotsky o Bronfenbrenner: casi ausentes.

- Enfoques críticos como la Teoría del Estigma de Goffman o la Teoría Crítica Racial: poco utilizados para analizar sesgos en LLMs.

El estudio sugiere que esto se debe a que la investigación en estas áreas requiere estudios a largo plazo, trata con datos sensibles (pacientes, estudiantes) y sus teorías son más difíciles de «traducir» a un algoritmo.

En resumen, la IA nos ve, sobre todo, como una fuente de herramientas de medición y de modelos cognitivos básicos, pero le cuesta más integrar la complejidad del comportamiento social, clínico y del desarrollo.

El «Mal Uso» Constructivo: El Caso de la Teoría de la Mente

Aquí es donde el artículo se vuelve más crítico y, para nosotros, más interesante. Los autores utilizan la Teoría de la Mente (ToM) como un caso de estudio para ilustrar cómo la IA a menudo «malinterpreta» los conceptos psicológicos.

Identificaron cuatro errores comunes:

- Sobregeneralización Conceptual: Los investigadores de IA a menudo usan el término «Teoría de la Mente» como una etiqueta general para cualquier tarea que implique inferencia social, sin distinguir entre las complejas subtareas que nosotros sabemos que existen (p. ej., reconocer una creencia falsa de primer orden vs. una de segundo orden).

- Citas Parciales e Incompletas: La mayoría de los artículos de IA citan una y otra vez los mismos dos o tres trabajos clásicos sobre ToM (como el de Premack de 1978 o el de Baron-Cohen de 1985). Ignoran décadas de investigación posterior que han matizado, complejizado e incluso cuestionado esos hallazgos iniciales. Por ejemplo, rara vez citan trabajos sobre el desarrollo progresivo de la ToM, que se alinearían mucho mejor con la forma en que las capacidades de los LLMs emergen por etapas.

- Malinterpretación de Hallazgos: A veces citan un estudio de neuroimagen que muestra la activación del surco temporal superior durante una tarea de ToM como «prueba» de que un LLM tiene un comportamiento social similar, mezclando niveles de análisis (biológico vs. conductual) de una manera que haría que cualquier psicólogo se estremeciera.

- Errores de Cita Secundaria: El problema más común. Un investigador de IA no lee el artículo original de psicología. En su lugar, cita a otro investigador de IA que resumió (a menudo, de forma simplificada) el concepto. Esto crea una especie de «teléfono descompuesto» académico que aleja cada vez más el uso del concepto de su significado original.

Riesgos de una psicología mal entendida

- Descontextualización: Se aplican teorías como la motivación o la creatividad sin considerar su base humana y social.

- Confusión terminológica: Términos como «atención» o «aprendizaje» tienen sentidos distintos en IA y psicología.

- Reproducción de sesgos: Sin marcos críticos, los modelos pueden amplificar estigmas sociales (por raza, género, salud mental).

- Reducción de la psicología a escalas o diagnósticos: Esto limita el potencial de la IA para comprender complejidades como el sufrimiento o el desarrollo.

Si aplicamos teorías psicológicas sin su contexto, no estamos comprendiendo los fenómenos humanos: estamos reduciendo complejidades a esquemas engañosamente simples.

¿Qué podemos hacer? Hacia un Puente Mejor Construido

Este estudio no es una crítica destructiva, sino una llamada de atención y una invitación a la colaboración. La psicología no es solo un «supermercado de ideas» para la IA. Nuestra disciplina tiene un rigor teórico y metodológico que es esencial para construir sistemas de IA más seguros, éticos y verdaderamente inteligentes.

El artículo concluye que la IA necesita:

- Responsabilidad Teórica: Entender las teorías en su contexto, con sus supuestos y limitaciones.

- Operacionalización Rigurosa: Usar nuestras herramientas de medición validadas en lugar de crear «tareas proxy» que carecen de validez de constructo.

- Colaboración Real y Equitativa: Trabajar con psicólogos desde el inicio del diseño de la investigación, no solo como consultores puntuales.

Tender el puente, no solo cruzarlo

El artículo científico que analizamos ofrece un mapeo valioso sobre cómo la IA está absorbiendo (y a veces distorsionando) teorías psicológicas. Como profesionales de esta ciencia, no podemos mantenernos al margen. Tenemos la oportunidad y la responsabilidad de influir en el diseño de tecnologías que ya están moldeando subjetividades, relaciones y sistemas educativos o clínicos.

Para nosotros, como psicólogos, el mensaje es claro: tenemos un asiento en la mesa del futuro tecnológico. El puente entre la IA y la psicología puede estar incompleto, pero nuestra disciplina tiene los planos, los materiales y la experiencia para ayudar a construirlo correctamente. Es hora de que nos escuchen, y de que nosotros nos hagamos oír.

Los modelos reconocen datos. Los psicólogos comprendemos personas. Solo con esa alianza podremos construir una inteligencia verdaderamente significativa.

Un regalo. Análisis con una herramienta de IA

Ya te he halabdo en una entrada, relacionada con las noticias, que NotebookLM se ha actualizado con una nueva función, las presentaciones en vídeo. En dicha noticia, te indicaba que solo estaba disponible en inglés, pero he conseguido generar tanto el contenido como el audio, en español (ya te contaré como lo he logrado).

El análisis obtenido es tan bueno, que he decidido publicarlo en Youtube y que lo tengas disponible, por eso, te lo dejo aquí abajo, por si te interesa verlo, creo que es, incluso mejor que el podcast.

📚 Referencias bibliográficas

Jiang, H., Wang, P., Yi, X., Xie, X., & Xiao, Z. (2025). The Incomplete Bridge: How AI Research (Mis)Engages with Psychology. Johns Hopkins University & Microsoft Research Asia. https://arxiv.org/abs/2507.22847v1